-

Postów

1661 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

28

Treść opublikowana przez Paq

-

Mikro sklep SEO z naciskiem na produkt czy kategorię ?

Paq odpowiedział(a) na stania.info temat w Dla początkujących

1. Tak, robić, ale zarazem musisz mieć świadomość, że konwersja z tych listingów będzie b. niska, pewnie poniżej 1 pkt. %. 2. Biznesowo Twoim zadaniem jest zrobić wszystko, żeby mieć możliwie jak największą rozpiętość produktową i cenową, bo w przeciwnym razie staniesz w miejscu. I to musisz uświadomić sobie już teraz. Czyli jeśli masz 20 SKU/EANów od 1 dostawcy, to poszukaj sobie jeszcze 2-3 żeby mieć ich możliwie jak najwięcej. Mała liczba produktów to taka typowa pułapka sklepów DTC (direct to customer, tj. sklepów producenckich), które mają 10, 20, 30 SKU/EAN i próbują nim handlować przez SEO, a sklep, który ma tak niską rozpiętość produktową (a co przez to idzie także pewnie cenową, materiałową itd.), będzie miał na tyle niską konwersję, że będziesz się z tym sklepem turlał przez lata i próbował to urentownić, i większości wypadków - guzik z tego jest. Żeby móc dzisiaj zbudować sklep w SEO i ściągać do niego ruch do kategorii, najlepiej być retailerem, bo retailer ma setki, tysiące produktów, więc każdy listing (kategorię) ma upchaną po uszy produktami i osiągnięcie sensownego poziomu konwersji nie jest wyzwaniem. Różnica w sprzedaży produktów w SEO a w Google PLA jest taka, że w SEO, to Twój listing (Twoje kategorie) są miejscem, z którego klient ma podjąć decyzję zakupową, więc liczba produktów w listingu jest kluczowa. W PLA nie ma to większego znaczenia, bo miejscem, z którego klient podejmuje decuzję zakupową jest sam SERP i wszystkie inne sklepy, które dostarczają do PLA swój plik feedowy. To fundamentalne różnice. 3. W sklepach o niskiej ilości SKU/EAN (produktów), problemem jest także sam dwell time, bo zdarzenia behawioralne będą dla Twojej domeny obciążające. Ruch z organica będzie Ci wchodził, odbijał się, a Ty Google'owi w ten sposób potwierdzisz tylko fakt, że nie powinieneś mieć TOP'ek, bo ruch się od Ciebie odbija i ląduje gdziekolwiek indziej. Zwykle widać to w DTC tak, że dojechać do TOP10 dojedziesz, ale utrzymanie się w TOP10 już nie jest takie proste, bo jak Twoim konkurentem jest sklep retail, który ma w listingu np. 200 SKU/EAN, a Ty masz 5, to żebyś stawał na głowie, z budowaniem pozycji dalej/skalowaniem nic się nie da zasadniczo zrobić. 4. Jeśli będziesz miał duplikaty w kartach produktowych, to nie ma z tym większego problemu, bo unikalny content i tak będziesz pchał do widoków kategorii - to Ci wystarczy. 5. Z kolei nawiązując do tematu: "Mikro sklep SEO z naciskiem na produkt czy kategorię ?" - to nie Ty podejmujesz decyzję o tym, co będziesz pozycjonował w SERPie, tylko search intent i wyniki. Jeśli w SERPie w TOP10 nie ma kart produktowych na zapytanie XYZ, to znaczy, że na to zapytanie XYZ Google nie chce mieć w ekspozycji kart produktowych (bo np. w TOP10 są same kategorie), to żebyś napchał nie wiadomo ile treści i linków w karty produktowe, do TOP10 nie wejdziesz. To nie Ty decydujesz o tym, jakiego rodzaju taksonomię będziesz pchał do SERPów (patrz: kategoria czy produkt), a Google. Zanim zaczniesz cokolwiek pozycjonować, sprawdzaj, co jest w wynikach, żeby odkryć search intent. Czasami trafisz na takie frazy, które przykładowo wyglądają z pozoru na transakcyjne (patrz: biżuteria do białej sukienki), a okazuje się, że są to zapytania utkane blogpostami albo odwrotnie. -

Strategie dobierania anchorów, czy coś się zmieniło?

Paq odpowiedział(a) na Farlicki temat w Pozycjonowanie i Optymalizacja

Materiał, który tutaj się Wam nie spodobał był offem z wewnętrznego spotkania w firmie, więc ma prawo do niektórych nie trafiać i jestem z tym okej. Wideo wycięliśmy i udostępniliśmy po to żeby pokazać, że pozyskiwanie linków EM z zewnętrznych serwisów niesie za sobą pewne ryzyko i w skrajnych wypadkach, ryzyko zupełnie niekontrolowane (właściciel postawił kopii tego serwisu X i kiedy analizowaliśmy profil linków tego URL'a wraz z upływem czasu, to 98% anchorów prowadzących do niego miało EMA i sporo wysiłków trzeba było podjąć, żeby to odwrócić). Podobne scenariusze widziałem wielokrotnie np. pozyskując linki z forów, które miały zbudowane URL'e na adresacjach dynamicznych (czyli generowane w nieskończoność, a wprowadzone do indeksu search query, widoki stronicowania itp.). W skrajnych okolicznościach pozyskanie linka z EMA po X miesiącach, albo latach potrafiło doprowadzić do 1 URL'a tysiące linków (właśnie z tym EMA), co było wysoce niepożądane. Więc jak pozyskujecie BL, patrzcie na szerszy kontekst i cykl życia serwisu (jeśli ogólnie miejscówka jest "zajechana" i właściciel nie ma pomysłu jak dalej monetyzować serwis, żeby móc go moderować albo utrzymywać przynajmniej w jako takiej kondycji, to lepiej taki serwis w ogóle sobie odpuścić, niż się potem z tym szarpać). Co do zasady EMA u siebie lub w serwisach osób, z którymi jesteś w jakiejś relacji (takiej relacji, że gdyby przyszło zmienić proporcje anchorów URL'a, to jesteś w stanie tym zarządzić). A w obcych serwisach brand, URL, phrase match + call to action. To też zależy czy robisz SEO agencyjne dla kogoś i chcesz minimalizować ryzyko, czy robisz to SEO dla siebie, czy to jest stara domena, czy świeża. Algorytm nie jest 0-1 w tym kontekście. -

Zlecę sprawdzenie indeksacji ok. 8-12 tys. URLi. Albo PW albo kontakt [dot] paq-studio.com. Mile widziana FV.

-

Planeta-seo :Wyszukiwarki internetowe – Ranking najpopularniejszych wyszukiwarek

Paq odpowiedział(a) na Newsbot temat w Do poczytania

Nie wiem co robi Bing tuż za Googlem (a dalej Yahoo!), skoro drugą największą wyszukiwarką już od kilku lat jest YouTube. -

Strona podobna do zblogowani.pl. Wkrótce zamykają.

Paq odpowiedział(a) na szczalpior temat w Dla początkujących

We kategorii wnętrza masz nasz projekt https://domzikely.pl Automatyczne zaciąganie wpisów po RSS jest w planach. -

@Stranek Z całym szacunkiem, ale wszystkie Twoje wątki albo dotyczą podpier*lania obcych treści i tłumaczenia tego translatorem, albo tak, jak teraz - synonimizowanie cudzych artykułów. Co wątek, to tylko pytania, jak zrobić żeby się nie narobić i co zrobić, żeby nikt Cię za to nie złapał. Te tematy nadają się do moderacji tak doprawdy.

-

Zajechana.

-

Podmieńcie nowy sklep w miejscu starego i jeśli się da, zachowajcie starą adresację URLi. To wszystko. Jeśli to niemożliwe, to przypilnujcie tylko przekierować 301, żeby nie utracić pozycji. 301 też Was rzecz jasna przed całością nie uratuje, bo przy zmianie całej adresacji bloga pozycje będziecie odbudowywali przez 6-8 miesięcy, ale dobre i to.

-

To jest fatalna mechanika, tj. żeby w linkowaniu wewnętrznym linkować do adresów dynamicznych, a które to adresy dynamiczne linkiem kanonicznym wskazują na URL pierwotny (właściwy).

-

Post powyżej zgłoszony, ale przy okazji, jeśli ktoś z Was szuka dla swoich ludzi czegoś wygodnego do siedzenia, to polecam Signal Q112 - to Chińczyk, ale z dobrych materiałów i ma naprawdę godną ergonomię. A w biurach wysiedzieliśmy już wiele różnych foteli.

-

Jeśli pozyskasz 1 link do swojej strony z jakiegoś forum dyskusyjnego, to będzie to wyglądało tak: 1 link i 1 domena odsyłająca. Jeśli z pozyskasz 5 linków do swojej strony z jakiegoś forum dyskusyjnego (z różnych wątków, miejsc), to będzie to wyglądało tak: 5 linków i 1 domena odsyłająca. Linki do zbiór wszystkich aktywności, wszystkich linków jakie prowadzą do Twojej strony. A odsyłające domeny to liczba zgrupowanych aktywności do pojedynczych domen.

-

Masowe wyszukiwanie danej frazy a podpowiedź google

Paq odpowiedział(a) na seba123 temat w Dla początkujących

Wygeneruje, ale takich niewolniczych grup nie ma. Lepiej będzie zlecić napisanie takiego bota na desktopa; do tego jakiś dobry VPN i przy odpowiednio dużej skali - wywołasz suggestion. Gdyby IP'ki z VPNa nie dawały rady, to możesz kupić dedykowane proxy z Hime My Ass. Ew można robić to przez mobile, szukaj pod pojęciem "Phone Farming". Nie wiem tylko co rozumiesz, pisząc: "ktoś tak próbował pozycjonować ?" - a co to ma do pozycjonowania? -

https://www.zgred.pl/blog/jak-znalezc-dobra-wygasla-domene-potrzebujesz-xenu-mocne-lacze-i-troche-czasu/

-

Pozycjonowanie Woocommerce przez początkującego - czy dobrze się za to zabieram?

Paq odpowiedział(a) na mlers temat w Dla początkujących

Linkowanie wewnętrzne tak; produkty - jeśli chcesz, też mogą być. Chodzi o content; Ty chciałeś upychać tam jakieś treści, a nie powinieneś tego robić, bo strony główne b. często kanibalizują kategorie. A to typowe, bo wiadomo, że główna przyjmuje na siebie 80% wszystkich linków zewnętrznych, więc czasami nawet 2-, 3-krotne powtórzenie jakiegoś słowa może powodować, że strona główna będzie wypychała kategorię w SERP'ach. A z kolei strony główne mają wyższy współczynnik odrzuceń w porównaniu do kategorii, więc paradoksalnie dochodzi do sytuacji, w której nie dość, że robot będzie wypychał na zapytanie "X" stronę główną niż kategorię, to po drugie - strony głównej w TOP 10 docelowo nie utrzymasz. Sprawdź sobie, jak wyglądają SERP'y dla zapytania "X" i zbadaj, jakiego rodzaju URL'e są w nim eksponowane. Jeśli wpiszesz jakiś money keyword, np. kosiarki spalinowe (nie ma ani 1 URL'a, który byłby stroną główną). Tak doprawdy - nie jestem w stanie omówić Ci wszystkich procesów, bo to, co wcześniej napisałem, czyli: "Linkowanie wewnętrzne tak; produkty - jeśli chcesz, też mogą być. Chodzi o content" - to też duże uproszczenie, bo anchory linków wewnętrznych produktów, jakie wyświetlasz na stronie głównej też mogą prowadzić w skrajnych scenariuszach do kanibalizacji. Obejrzyj sobie stary materiał na naszym kanale, może coś Ci się rozjaśni: https://youtu.be/OLQ5n_xChJo123 - mówię w nim w oparciu o przykład sklepu internetowego, ale przykład jest analogiczny. Zwróć uwagę, jak wygląda sklep https://dodukata.pl - co prawda w nim nie ma typowej architektury informacji, ale zwróć uwagę, że strona główna jest tylko landing page'm spychającym użytkownika do właściwej podstrony, czyli https://dodukata.pl/czesci-ducati/ Gdyby strona główna zwierała słowa "Ducati części", "Częśći Ducati" i podobne, to miałbym trudność w poprowadzeniu robota tak, jak tego chciałem. Dzięki temu, że strona główna jest zubożała w zawartość jako taką, nigdy nie będzie kanibalizowała właściwych podstron, które docelowo mają zbierać ruch. To też nie znaczy, że każdy sklep ma tak wyglądać, tj. jego strona główna musi być tak płaska, zubożała w content, ale powinieneś sobie pomyśleć o tym szerzej. Za każdym razem kontekst jest nieco inny, grunt, żebyś zdawał sobie sprawę z problemu. Nie. Możesz ew sprawdzić, czy Majesticseo jest tańszy od Ahrefs, ale nie ma dzisiaj już na rynku darmowych toolsów, które wnosiłyby jakikolwiek value. Obejrzyj materiał na temat osadzania bloga w katalogu - tam masz przedstawiony też wątek skonsolidowanej, albo osobnej architektury informacji: https://youtu.be/ltiREh6VYTQ Nie. Nadal nie rozumiem, skąd w ogóle wpadłeś na ten pomysł, co on miałby implikować, ale niezależnie od tego, jak na to wpadłeś, odpowiedź brzmi - nie, Pytałeś, co można Ci polecić, więc podrzuciłem co mamy przepracowane. Miejscówek jakie są sprzedawane przez sklepy, które wymieniłeś nie znam, więc nie mam jak się do nich ustosunkować. I pełna zgoda do tego co napisał kolega wyżej - jeśli w kontekście e-commerce ten koszt startowy jest zbyt wysoki, to będzie Wam trudno zrobić jakieś wyniki. A te pakiety to są i takie, że wrzucasz, zapominasz i lecisz dalej, bo jeśli miałbyś czekać na jakieś zauważalne efekty z tych pakietów, to zbyt wielu się nie spodziewaj. Ale indeksację Ci poprawią, więc zawsze coś. Żeby zrobić coś lepiej, to trzeba wiedzieć, co wymaga poprawy. Przecież nie chodzi o to, żeby powielać mechaniki, content i BL pierwszych 3 domen z SERP'ów na zapytanie "X", tylko zbadać czy biznes ma zasoby, żeby zbliżyć się do czołówki. Jeśli zbadasz analizą ilościową i jakościową korelację między BL a contentem i pozycjami w SERP'ach (+ wiek domen + rotację wyników organicznych), to masz już na czym pracować. Z takiej analizy wykluczasz tuzy - czyli np. nie pomijasz w tej analizie Allegro, albo OLX, bo to, że Allegro np. nie ma na zapytanie X dużo contentu będzie zaburzało próbkę i analizę. Paq -

Pozycjonowanie Woocommerce przez początkującego - czy dobrze się za to zabieram?

Paq odpowiedział(a) na mlers temat w Dla początkujących

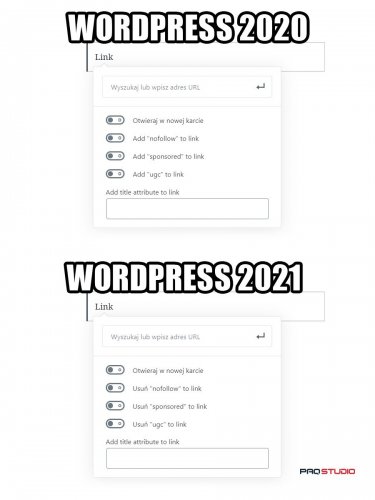

2.1 Strony głównej nie pozycjonuje się na żadne money keywords. Co najwyżej na brand. Jeśli wypełnisz stronę główną w content związany z zapytaniem, które tak naprawdę powinno zepchnąć użytkownika na zbiór produktów, to będziesz szarpał się z kanibalizacją. 2.2. Content wypełnia się w oparciu o liczby i korelację, a nie sztywno narzucone wartości liczbowe. To, ile treści potrzebujesz, w jakim zagęszczeniu, ile exactów, ile partial keywords itd. policzysz korzystając z Surfera SEO i zestawiając te dane z Ahrefs. 2.3. A blog będzie miał osobną architekturę informacji dla siebie, czy będzie dziedziczył architekturę informacji po sklepie? 2.4 Odpuść sobie Yoasta na rzecz All in One SEO Pack - ten drugi pewnie też będzie wymagał miejscami dopisania czegoś ręcznie, ale przynajmniej nie ma jakichś dziwnych akcji - tj. przy aktualizacjach nigdy nie zdarzyło się, żeby w All in One SEO Packu rozjechały się canonicale, noindexy albo inne tematy. A w Yoast tak. Inna sprawa, że Yoast ma fatalne, nietechniczne tłumaczenie i trzeba się doszukiwać, która funkcja tak naprawdę co wstrzykuje do kodu źródłowego. A po drugie - Yoast jest tylko wtyczką, a nie narzędziem data driven. To, że w Yoast spełnisz jakieś tam z góry zaprojektowane przez kogoś zagęszczenie słów kluczowych nijak ma się do SERP'ów. Nie myśl o tym w tych kategoriach. Tego nie rozumiem. Weź na start pakiety Pozycjonusza: https://www.pozycjonusz.pl/pakiet-trustrank/ (pakiet 2) + to https://www.pozycjonusz.pl/pakiet-sklepowy/ Wiele nie poczujesz, ale przynajmniej bot po tym crawluje, penalizacji za to nie dostaniesz; no na start coś tam jest. -

Nie, zupełnie nie tak. 1. Po co w ogóle chcesz pozycjonować stronę główną na cokolwiek? Strona główna powinna być zubożała w zawartość tak bardzo, jak tylko zubożała być może. Stron głównych nie pozycjonuje się na żadne zapytania sprzedażowe - właśnie po to, aby nie kanibalizowała Ci ruchu napływającego na podstrony. Bo do podstrony jesteś w stanie przypisać np. dane strukturalne, a do głównej nie. Zresztą sprawdź sobie, jak wyglądają SERPy, np. dla zapytania o jakąś usługę, albo produkt. w 90% przypadkach eksponowane są URLe podstron, a nie stron głównych. To nie 2012 r., gdzie wszystkie keywordy pchało się na główną i tylko nią pchało w SERP'ach. 2. Błędnie rozumiesz przepływ linkjuice, ale to jest temat na cały artykuł, więc daruję sobie. Zasadniczo - linkjuice zbierany przez podstronę X jest rozkładany linkowaniem wewnętrznym po podstronach dalej. A strona główna pojawia się w tej narracji najczęściej, bo co typowe - przyjmuje na siebie największą liczbę linków zewnętrznych.

-

Google po raz kolejny poucza o linkach sponsorowanych czy gościnnych

Paq odpowiedział(a) na s_matysik temat w Pogaduszki

-

Platforma (2019)

-

Ceny pod opisami produktu w google ( Organiczne wyszukiwanie )

Paq odpowiedział(a) na Molarr temat w Dla początkujących

@Molarr Zleć to komuś, np. w dziale ogłoszenia, albo poszukaj wtyczek do osadzania danych strukturalnych. Przecież nie wiemy nawet jakiego CMS'a dotczy Twoje pytanie, więc nikt Ci takich rad nie udzieli. A nawet gdybyśmy wiedzieli, to kod może wyglądać inaczej w zależności od kompilacji silnika, theme'u itd. - to jest zadanie kontekstowe do ogarnięcia przez frontendowca albo backendowca, a już na pewno proces do przeprowadzenia Cię tutaj na forum, wklejając co drugiego posta screena. PS. Ten mój post to żadna złośliwość. Po prostu jeśli w oparciu o dokumentację, jaką Ci podesłaliśmy, nie jesteś w stanie przejść przez ten proces, to po prostu oddaj to na zewnątrz, nie widzę innej opcji. -

Ceny pod opisami produktu w google ( Organiczne wyszukiwanie )

Paq odpowiedział(a) na Molarr temat w Dla początkujących

price + priceCurrency z https://schema.org/PriceSpecification -

Nie wystarczy, bo zaplecze musi być podlinkowane, żeby mogło w ogóle moc przekazywać. To, że Ty sobie nastawiasz nawet jakichś 1000 zapleczówek, to jeśli bot nie będzie ich odwiedzał regularnie (a nie będzie, jeśli nie będziesz pozyskiwał do nich linków), to wartość takiego zaplecza jest zerowa.

-

To poziom podlinkowania zaplecza jest determinantem tego, ile linkjuice'u zaplecze przeniesie na docelową, więc pomysł z przenoszeniem zawartości co roku pod inny adres tylko po to, żeby nie zapłacić 55 zł za domenę jest w ogóle z czapy. Będziesz co roku porzucał alias, stawiał w innym miejscu i znów powtarzał proces linkowania (który jest najdroższym procesem ze wszystkich działań jakie podejmuje się wobec zaplecza).

-

@phillix To pozwolę sobie podrzucić swój materiał, bo w nim omawiam Twoje pytanie: https://youtu.be/qogl5FmBWvs

-

Index czy Noindex? Duplikowane ogłoszenia

Paq odpowiedział(a) na grubapanda temat w Dla początkujących

Masz trudny orzech do zgryzienia, bo z jednej strony - jasne - można dawać noindex, ale zakładając, że każde ogłoszenie w Twoim serwisie jest duplikatem (a na 99% tak jest), to trzymanie tylko kilkunastu, kilkudziesięciu stron w indeksie może nieoczywiście wpłynąć na autorytet całej domeny. Ratio podstron, jakie pozwalasz indeksować botowi vs tych, które nie pozwalasz będzie dziwne i musiałbyś zrobić test, jak taka mechanika wpłynie na budowę zasięgów organicznych. IMO przy odpowiednio dużej skali - patologia i nie jest to rozwiązanie docelowe. Z drugiej strony duża liczba duplikatów to też trudny temat do indeksacji, ale jeśli po prostu te duplikaty są main contentem Twojego serwisu (i innego contentu w zasadzie nie ma), to dlaczego miałbyś tego nie indeksować? Generalnie serwisy o architekturze zbliżonej do serwisu ogłoszeniowego, katalogu, gdzie operuje się na duplikatach to w 2020 r. trudny temat i wymagają niewąskich nakładów finansowych. Bo to, że nie masz kontroli nad contentem to jedno, ale o ile user generated content w przypadku forum dyskusyjnego ma content unikalny, to Ty będziesz miał i tak te duplikaty i nie masz żadnych argumentów, żeby zmusić użytkownika do wygenerowania nowego opisu - bo nie jesteś OtoDom'em, żeby taką narrację móc prowadzić. Prawda jest taka, że taki obniżony autorytet domeny z tytułu operowania duplikatami jako main content, można wyciągnąć tylko backlinkiem, ale tylko takim mega tłustym. Powyżej pewnego poziomu (np. OLX, Allegro, Ceneo) itd. robot ma generalnie w du*ie, co Ty tam masz w zawartości - ich autorytet jest tak wysoki, że czy mają duplikaty, czy nie, to i tak będą w TOP'ie. Równolegle możesz też produkować tony unikalnego contentu np. na blogu, żeby utrzymać rozsądne ratio unikalnego contentu vs duplikatów, ale to też tanie nie jest. Bez grubszej inwestycji, to w ogóle bym w temat serwisu ogłoszeniowego nie wchodził. A inna sprawa, że jak nawet wydasz XYZ, to efekt będzie taki, że i tak tego nie spieniężysz, bo w branży ogłoszeniowej albo jesteż liderem w swojej kategorii i zbierasz cały ruch, albo nie ma Cię wcale. Pozdrawiam -

@kwk9k O mocy zaplecza decyduje jego profil linków, a nie CMS, na jakim stoi. Tak, jak napisał @Aleksiejs - bez znaczenia.